Tal y como estaba previsto, esta vez sin retrasos, ha sido anunciado el lanzamiento Ubuntu 24.04 LTS, la nueva versión de soporte extendido de la distribución de Canonical y, cada vez con menos brío, pero todavía de manera clara, el gran representante del escritorio Linux… Claro que no solo del escritorio, vive Ubuntu. Más bien al contrario, aunque aquí le dediquemos especial atención al mundo del PC.

Ubuntu 24.04 LTS llega en la forma de Ubuntu Desktop, con su edición principal basada en el escritorio GNOME y otros tantos «sabores» oficiales con los entornos de escritorio más populares de Linux, así ofrece imágenes de instalación dedicadas a servidores, a dispositivos embebidos y el Internet de las Cosas, se distribuye asimismo a través de las grandes plataformas de servicios en la nube… En esta publicación, sin embargo, nos enfocamos en el PC.

Ubuntu 24.04 LTS: novedades generales

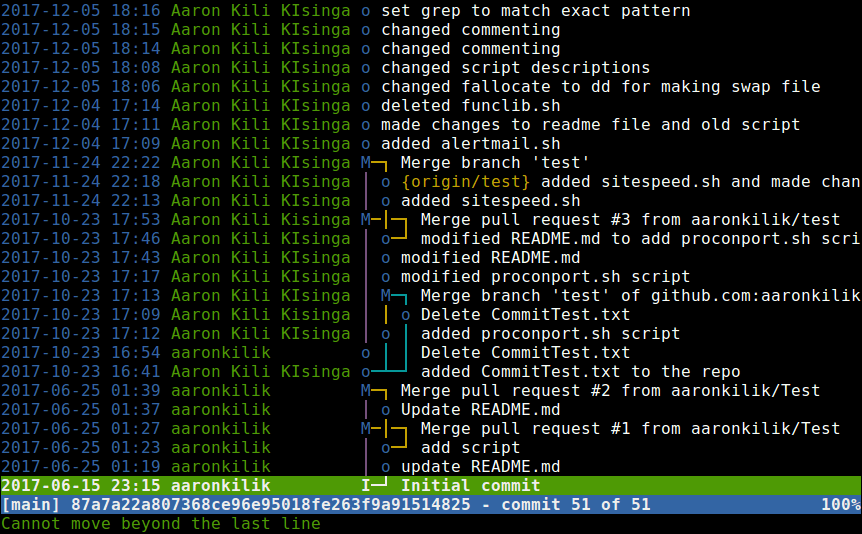

Ubuntu tiene muchas formas, pero solo un fondo y este se construye con una serie de componentes base compartidos entre los que destaca el kernel Linux 6.8, el sistema de inicio systemd 255 y la pila gráfica Mesa 24.0 (Ubuntu suministra también los controladores privativos de NVIDIA), entre muchos otros. Cabe mencionar el estreno de Netplan 1.0, primera versión estable del nuevo gestor de redes de Canonical y backend predeterminado de NetworkManager.

Siguiendo con los componentes basa del escritorio, Ubuntu 24.04 LTS incluye de serie nuevas versiones de NetworkManager (1.46), Pipewire (1.0.4), BlueZ (5.72), Cairo (1.18), Poppler (24.02), xdg-desktop-portal (1.18); así como nuevas versiones en la cadena de herramientas: GCC 14, binutils 2.42, glibc to 2.39, Python 3.12, OpenJDK 21, LLVM 18, Rust 1.75,Golang 1.22, .NET 8… Más datos, más específicos, en las notas de lanzamiento.

En términos más llanos, un cambio relevante en esta nueva versión de Ubuntu que afecta por igual a todas las ediciones oficiales es el de Thunderbird, ya que el gestor de correo electrónico de Mozilla y el predeterminado en varios de los sabores, se sirve a partir de ahora única y exclusivamente como paquete Snap, el formato de aplicaciones desarrollado por Canonical para el escritorio Linux. Sigue así lo marcado por Firefox y otras aplicaciones. Con todo, en Thunderbird están por la labor y colaborarán en su mantenimiento.

Ubuntu 24.04 LTS estrena también Firmware Updater, como su nombre indica, una utilidad independiente con la que actualizar el firmware, basada en fwupd y que no está presente en todos los sabores, pero sí en varios de ellos.

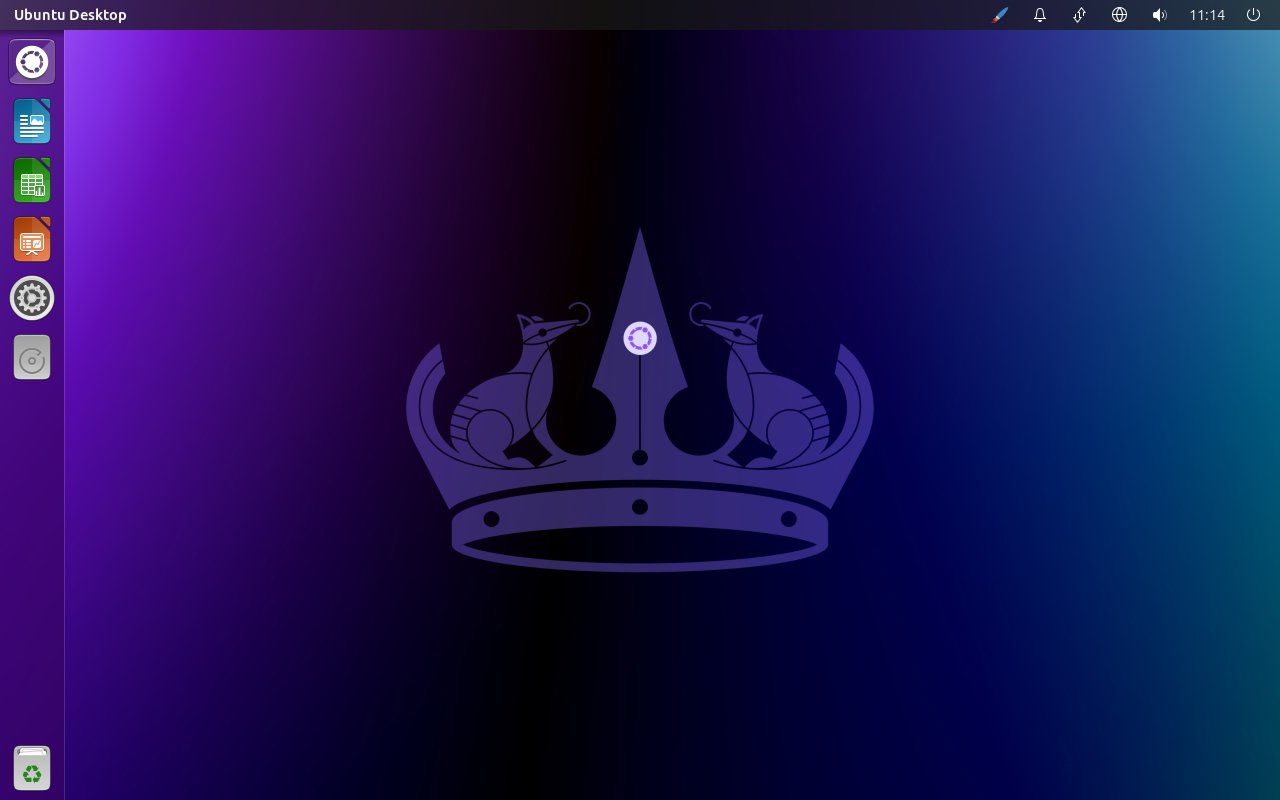

Ubuntu 24.04 LTS

En lo que respecta a la edición principal de Ubuntu, son varios los cambios que merece la pena comentar, aunque no todos van a gustar por igual. El primero que notará el usuario que se lance a instalar esta actualización en limpio es, de hecho, el nuevo instalador del sistema de Ubuntu, desarrollado con Flutter y estrenado el año pasado en Ubuntu 23.04, el cual incorpora varias novedades en su haber.

Las novedades del instalador del sistema de Ubuntu 24.04 LTS contemplan cambios en diversos apartados, tanto en las capacidadades de configuración, que mejoran de manera notable, como en el soporte de accesibilidad. Asimismo, se ha renovado el modo de instalación en lo que a la selección de aplicaciones predeterminadas se refiere. La opción por defecto es ahora la mínima, con una ampliada para quien desee un mayor número de aplicaciones preinstaladas.

Para más datos, te recomendamos echar un vistazo a nuevo tutorial de instalación de Ubuntu 24.04 LTS (en preparación), donde te guiamos paso por paso por el proceso y te detallamos todas las opciones disponibles.

Entrando ya en el escritorio, la gran novedad de Ubuntu 24.04 LTS es, obviamente, GNOME 46, la flamante versión del entorno de escritorio, lanzada a finales del mes pasado con diferentes novedades que repasamos en ese artículo. Claro que si no tocas Ubuntu desde la anterior LTS, el acumulado es mucho mayor e incluye lo que trajo GNOME 45, GNOME 44 y GNOME 43, que no es poco. De hecho, es tanto que no podemos resumirlo en unas pocas palabras, así que ahí tienes todas las referencias por si quieres saber más.

Por último, un detalle controvertido: si, precisamente con la anterior LTS, Ubuntu 22.04, se atrevieron a poner Wayland por defecto incluso en configuraciones con gráficas NVIDIA, aunque más tarde reculasen en cierta medida, en Ubuntu 24.04 ha sucedido lo contrario: Wayland queda relegado a la elección manual al iniciar sesión, salvo en determinadas configuraciones. Sin importar la configuración que se emplee, en protocolo gráfico de nueva generación del escritorio Linux se ha caído del lugar de privilegio. Se trata de un cambio que no parece estar especificado en ningún sitio, pero del que se puede leer bastante por ahí y que hemos comprobado de primera mano.

Ubuntu 24.04 LTS, sabores oficiales

Como es bien conocido, Ubuntu no hay una, sino varias, aunque se las conoce mejor por el apelativo de «sabores». Sabores de una distribución Linux de misma base, pero con diferentes imágenes de instalación, según el entorno de escritorio que gobierne el sistema.

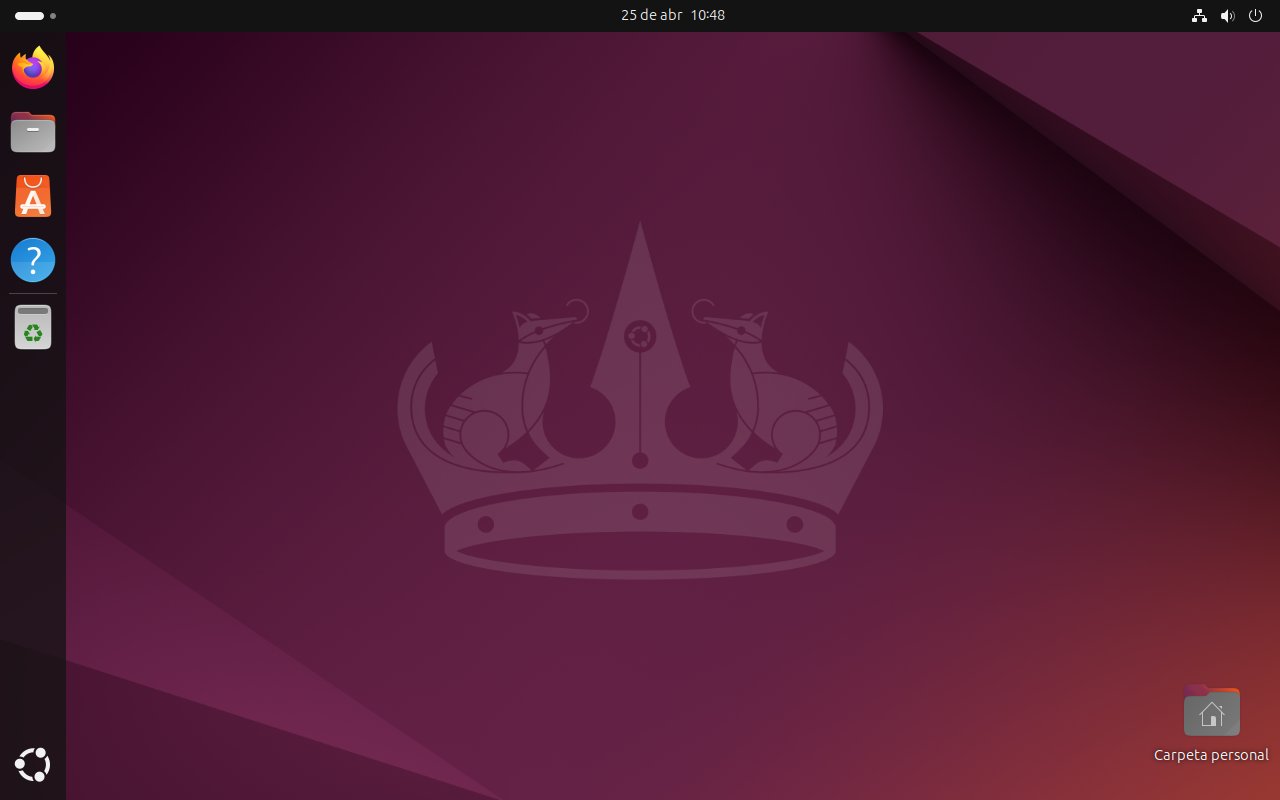

Kubuntu 24.04 LTS

De todos los sabores de Ubuntu, Kubuntu es sin duda el más interesante, por ofrecer el entorno de escritorio más moderno y potente junto con el de GNOME. En este sentido y como ya se sabía, Kubuntu 24.04 LTS se mantiene fiel a KDE Plasma 5.27 y KDE Gear 23.08, aunque como gran novedad tiene la adopción del instalador de sistema Calamares.

Más información en las notas de lanzamiento.

Xubuntu 24.04 LTS

Otra edición interesante, en este caso por la estabilidad en forma y fondo que transmite es Xubuntu, con un entorno de escritorio Xfce 4.18 bastante actualizado en relación a sus componentes. Apuesta, eso sí, por el mismo instalador de sistema de Ubuntu.

Más información en las notas de lanzamiento.

Ubuntu Budgie 24.04 LTS

Ubuntu Budgie es otro sabor que cambio poco, aunque al igual que Xubuntu, ha adoptado el instalador de sistema de Canonical. La versión del escritorio es Bugdie 10.9 con algunas novedades por encima.

Más información en las notas de lanzamiento.

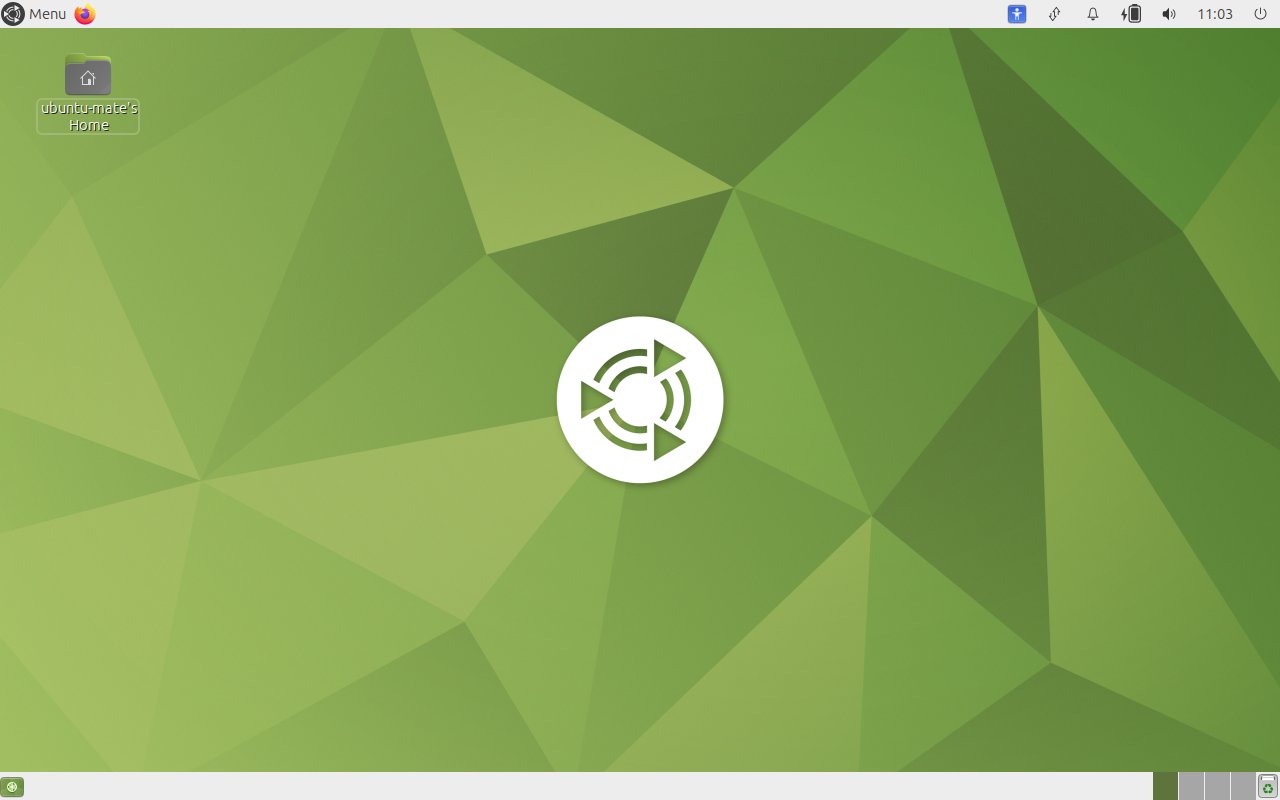

Ubuntu MATE 24.04 LTS

Los más cafeteros o aquellos no conformes con lo que aporta Xubuntu, siguen teniendo en Ubuntu MATE (el heredero de GNOME 2) su refugio, uno en el que las cosas tampoco cambian mucho. De nuevo, con la excepción del nuevo instalador de sistema, ya que la versión del escritorio sigue siendo MATE 1.26, con varias actualizaciones encima.

Más información en las notas de lanzamiento.

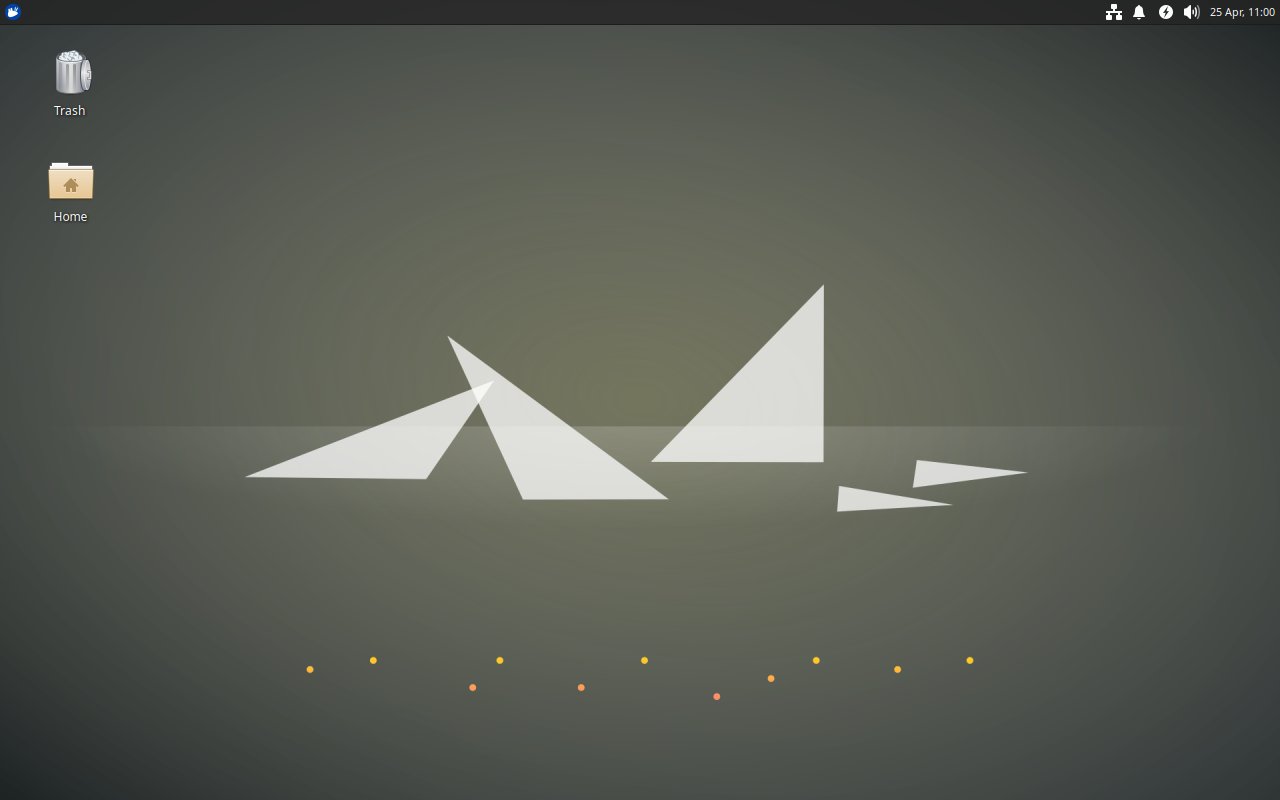

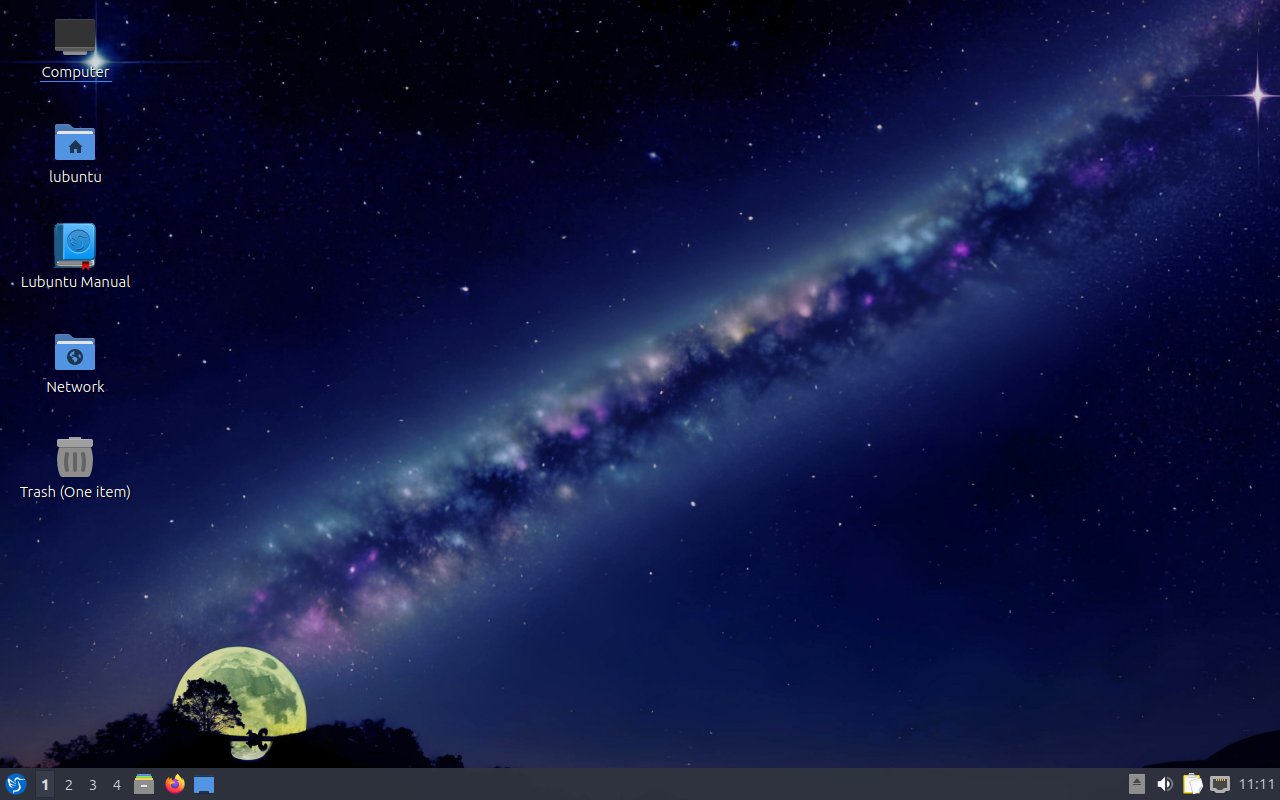

Lubuntu 24.04 LTS

Lubuntu es el sabor ligero, basado en el escritorio LXQt 1.4, al igual que KDE Plasma, basado en las interfaces gráficas de Qt, y seguramente por ello otro que ha optado por el instalador de sistema Calamares.

Más información en las notas de lanzamiento.

Ubuntu Unity 24.04 LTS

Claro que si de «herederos» va la cosa, Ubuntu Unity es uno de los más destacados, al mantener viva la llama del ya clásico escritorio Unity desarrollado originalmente por Canonical. Pues bien, este sabor continúa usando Unity 7.7, algo más actualizado, al tiempo que se ha pasado al instalador de sistema Calamares.

Más información en las notas de lanzamiento.

Ubuntu Cinnamon 24.04 LTS

El último sabor oficial en sumarse a la oferta de Canonical para el escritorio de PC fue Ubuntu Cinnamon, con Cinnamon 6.0 y el nuevo instalador de Ubuntu como piezas clave.

Más información en las notas de lanzamiento.

Ubuntu Studio, Edubuntu y Ubuntu Kylin

Ubuntu Studio, Edubuntu y Ubuntu Kylin son otros tres sabores oficiales de Ubuntu, pero no como el resto, de propósito general: el primero se enfoca en el sector multimedia, el segundo en el sector educativo y el tercero tiene su nicho de usuario en el mercado chino. En todo caso, si estás interesado en alguno de ellos, a continuación puedes ampliar la información al respecto:

- Ubuntu Studio 24.04 LTS, notas de lanzamiento.

- Edubuntu 24.04 LTS, notas de lanzamiento.

- Ubuntu Kylin 24.04 LTS, notas de lanzamiento.

Descarga Ubuntu 24.04 LTS

Te dejamos ya con la descarga de Ubuntu 24.04 LTS y familia. Ten en cuenta que las imágenes de instalación se distribuyen tanto mediante descarga directa como a través de la red BitTorrente, por lo que si la velocidad de descarga no es óptima, prueba a cambiar.

Para terminar, el vídeo de presentación oficial ed Ubuntu 24.04 LTS, en el que Canonical aprovecha para hacer un brevísimo repaso a los 20 años de Ubuntu (se cumplirán a finales de este año).

Fuente | MuyLinux